آیا تا کنون به فکر افتادهاید که الگوریتمهای هوش مصنوعی تا چه حد دقیق هستند؟ آیا امکان گول زدن رایانه وجود دارد؟ برای آشنایی با آزمایشهای انجام شده در این زمینه با مجله فناوریهای توان افزا و پوشیدنی همراه باشید.

به دام انداختن اتومبیل های خودران

الگوریتمهای هوشمند در انجام وظایفی مانند به خاطر سپردن تعداد زیادی از دادهها و دسته بندیها، خوشهبندی ها و اساسا ترتیببندی اطلاعات بر اساس معیارهای خاص، عالی هستند. این خصوصیت از یک دیدگاه مانند یک منبع بیپایان دانش به نظر میرسد. ولی از دیدگاهی دیگر مانند حجم عظیمی از اطلاعات بیهدف است. یک متخصص در زمینه اتومبیلهای خودران از این خصوصیت برای به دام انداختن اتومبیلهای خودران استفاده کرده است. به تصور او، نخستین چیزهایی که اتومبیلهای خودران یاد میگیرند، علائم جاده ای است. برای مثال یک راننده هرگز مجاز نیست از روی خط چین و خط مستقیم در کنار خیابان عبور کند. در این صورت وقتی یک اتومبیل خودران مانند تصویر زیر درون دایرهای به این شکل قرار میگیرد، نباید هیچ حرکتی انجام دهد.

این تنها نمونهای نیست که نشان میدهد چگونه میتوان اتومبیلهای خودران را فریب داد. در ماه مارس ۲۰۱۹، آزمایشگاه Tencent’s Keen Security گزارشی در مورد آزمایش برای فریب دادن یک تسلا مدل S منتشر کرد. آن توانستند تنها با قرار دادن سه علامت خط راست کنار جاده، مسیر اتومبیل را به سمت ترافیک تغییر دهند. سامانه خودران اتومبیل،که به بینایی رایانه ای آن متکی است، علائم را تشخیص داد. سپس آنها را به معنی انحراف مسیر به چپ تفسیر و ماشین را به آن سمت هدایت کرده است. چنین اشتباهی در واقعیت میتواند کشنده باشد. اما خوشبختانه این فقط آزمایشی برای ارزیابی امنیت سامانه خودران در برابر هکرها بود. به نظر میرسد متخصصان تسلا هنوز کارهایی برای انجام دارند.

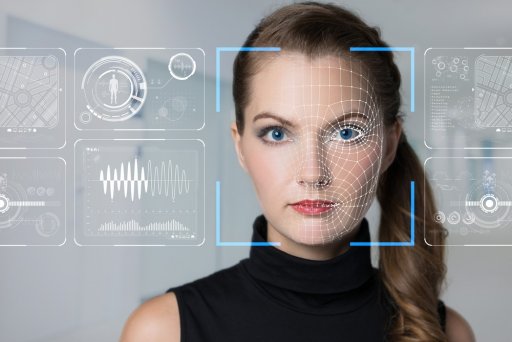

چگونه میتوان خود را از سامانه تشخیص چهره مخفی کرد؟

الگوریتمهای هوش مصنوعی به شکلهای دیگری نیز فریب میخورند. در سال ۲۰۱۹ گروهی از مهندسان دانشگاه KU Leuven در بلژیک نشان دادند که چگونه میتوان سامانه هوش مصنوعی تشخیص چهره را با یک الگوی چاپی ساده فریب داد. همانطور که پژوهشگران گزارش میدهند: “ما معتقدیم اگر این روش را با یک برنامه شبیه ساز لباس ترکیب کنیم، میتوان تیشرتی طراحی کرد که شخص را کاملا از دید دوربینهای نظارت خودکار مخفی کند.”

دانشمندان علوم رایانه به طور منظم سامانههای یادگیری عمیق را با نمونههای اصطلاحا ” خصمانه” آزمایش میکنند. به این روش، هوش مصنوعی، آنها را در طبقه بندیهای نادرست قرار میدهد و محدودیتهای احتمالی روشهای یادگیری عمیق فعلی ظاهر میشود. طراحی تیشرت نیز یکی از همین نمونه های آزمایشی است. آزمایش با استفاده از نمونههای خصمانه برای اولین بار در سال ۲۰۰۴ و برای دور زدن فیلترهای هرزنامه با استفاده از روشهای ساخت هرزنامه مورد استفاده قرار گرفت. دانشمند این آزمایشها را برای تمام مدلهای یادگیری ماشین و در طیف گسترده ای از دادهها، از جمله تصاویر، صوت، متن و سایر ورودیها انجام میدهند.

نمونه ای از پژوهشهای سنجش دقت هوش مصنوعی

به عنوان مثال، در تحقیقی که توسط متخصصان دانشگاه Wyoming انجام شد، دانشمندان نشان دادند که تولید تصاویر کاملاً غیر قابل تشخیص برای انسان آسان است. اما شبکههای عصبی عمیق پیشرفته با اطمینان ۹۹٫۹۹ درصد اشیاء را قابل تشخیص میداند.

در طرحی دیگر که با همکاری گوگل انجام شد، گروه تحقیقاتی Dawn Song، استاد دانشگاه Berkeley و متخصص در مطالعه خطرات امنیتی مربوط به هوش مصنوعی و یادگیری ماشین، در زمینه آموزش الگوریتمهای یادگیری ماشین برای تولید پیامهای خودکار ایمیل پژوهش کردند. تلاشهای آنها نشان داد که با ایجاد پیامهای صحیح، میتوان اطلاعات حساس مانند شماره کارت اعتباری افراد را از آن استخراج کرد. گوگل از این یافته برای محافظت از Smart Compose، ابزاری که به طور خودکار در Gmail متن تولید میکند، در برابر این دسته از خطرات، استفاده کرد.

بیشتر بخوانیم:

ارتباط میان هوش مصنوعی و یادگیری ماشین

هفت ناتوانی هوش مصنوعی در بهداشت و درمان(بخش نخست)

هفت ناتوانی هوش مصنوعی در بهداشت و درمان(بخش دوم)

منبع: medicalfuturist

«استفاده و بازنشر مطالب تنها با ذکر لینک منبع و نام (مجله فناوریهای توان افزا و پوشیدنی) مجاز است.»